开源mrcp-client-java版本

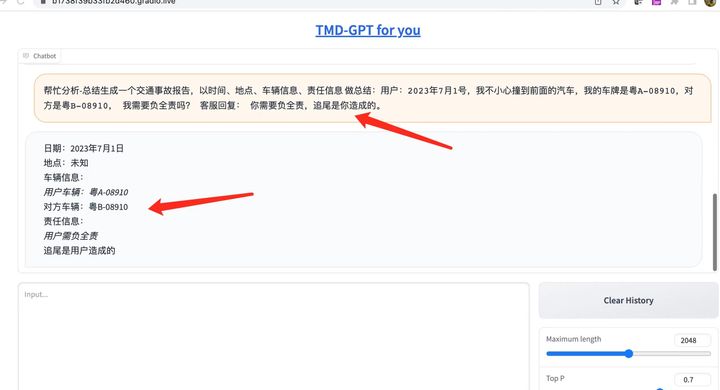

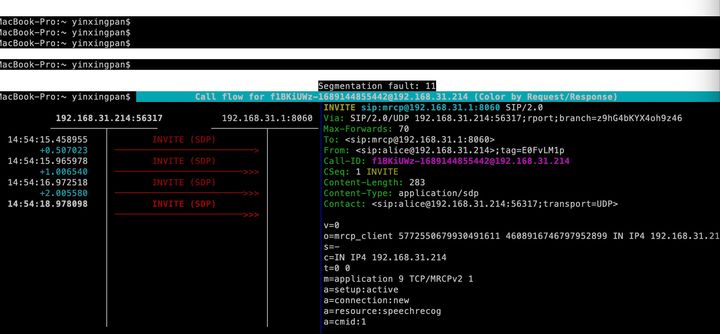

我们已经实现了 基于sip协议-mrcpv2协议的 mrcp-client java版本。

机缘巧合下,我们实现了 mrcp-client java版本。

我们查看了github上开源的mrcp相关的有node、c++、java版本的,但是java版本的只支持mrcp协议不支持sip协议。 因此我们萌生了自己动手实现一个sip+mrcpv2版本的java服务。

1:mrcp4j年久失修,里面有一些处理mrcp协议的bug。

mrcp4j 没有sip协议处理

2:我们基于peers实现sip协议。

我们先开源client,基于client你可以实现自定义音频文件传入给client,并通过client将媒体流传给mrcp-server服务, 同时client能够监听和处理来自server的asr信息。

以下是代码情况,近期请期待。